Testez VOTRE Entreprise en Minutes

Créez votre compte et lancez votre chatbot IA en quelques minutes. Entièrement personnalisable, aucun codage requis - commencez à engager vos clients instantanément!

La magie derrière la fenêtre de discussion

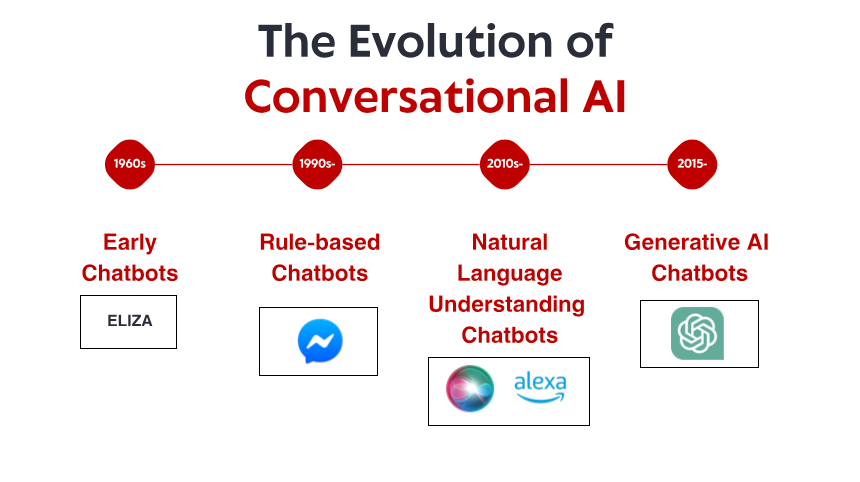

L'apparente simplicité des chatbots modernes masque un orchestre technologique incroyablement sophistiqué en coulisses. Ce qui ressemble à un simple échange textuel implique plusieurs systèmes d'IA spécialisés travaillant de concert : ils traitent votre langage, récupèrent les informations pertinentes, génèrent des réponses appropriées et apprennent constamment des interactions.

Ayant passé des années à développer et à mettre en œuvre des systèmes de chatbot pour divers secteurs, j'ai été aux premières loges de leur évolution remarquable. De nombreux utilisateurs sont surpris d'apprendre que les chatbots modernes ne sont pas des programmes d'IA isolés, mais plutôt des écosystèmes complexes de composants spécialisés fonctionnant ensemble. Comprendre ces composants permet non seulement de démystifier ce qui peut parfois ressembler à de la magie technologique, mais aussi de mieux apprécier leurs capacités et leurs limites.

Dans cette exploration, nous lèverons le voile sur les chatbots modernes afin de comprendre les technologies clés qui les alimentent, comment ces systèmes sont entraînés et comment ils surmontent les défis fondamentaux du langage humain. Que vous envisagiez d'implémenter un chatbot pour votre entreprise ou que vous soyez simplement curieux de la technologie avec laquelle vous interagissez au quotidien, cette visite des coulisses vous offrira un aperçu précieux de l'une des applications les plus visibles de l'IA.

La Fondation : les grands modèles de langage

L'ampleur de ces modèles est difficile à appréhender. Les LLM les plus volumineux comportent des centaines de milliards de paramètres – les valeurs ajustables que le modèle utilise pour faire des prédictions. Au cours de l'entraînement, ces paramètres sont progressivement affinés à mesure que le modèle traite d'énormes ensembles de données composés de livres, d'articles, de sites web, de référentiels de code et d'autres textes, représentant souvent des milliards de mots.

Grâce à cet apprentissage, les modèles de langage développent une compréhension statistique du fonctionnement du langage. Ils apprennent le vocabulaire, la grammaire, des faits sur le monde, des schémas de raisonnement et même un certain sens commun. Il est important de noter qu'ils ne se contentent pas de mémoriser leurs données d'entraînement : ils apprennent des schémas généralisables qui leur permettent de traiter de nouvelles entrées qu'ils n'ont jamais vues auparavant.

Lorsque vous envoyez un message à un chatbot utilisant un LLM, votre texte est d'abord converti en représentations numériques appelées jetons. Le modèle traite ces jetons grâce à ses nombreuses couches de connexions neuronales, produisant ainsi des distributions de probabilités indiquant les jetons qui doivent apparaître ensuite dans une réponse. Le système convertit ensuite ces jetons en texte lisible par l'humain.

Les modèles de langage les plus avancés aujourd'hui incluent :

GPT-4 : Le modèle d'OpenAI, reconnu pour ses capacités de raisonnement puissantes et ses vastes connaissances, alimente ChatGPT et de nombreuses autres applications commerciales.

Claude : La famille de modèles d'Anthropic, conçue pour privilégier l'utilité, l'innocuité et l'honnêteté.

Llama 3 : Les modèles à pondération ouverte de Meta, qui ont démocratisé l'accès à la puissante technologie LLM.

Gemini : Les modèles multimodaux de Google, capables de traiter à la fois du texte et des images.

Mistral : Une famille de modèles performants offrant des performances impressionnantes malgré un nombre réduit de paramètres.

Malgré leurs capacités remarquables, les modèles de langage de base présentent à eux seuls des limites importantes en tant qu'agents conversationnels. Ils n'ont pas accès à l'information en temps réel, ne peuvent pas effectuer de recherches sur le web ou dans les bases de données pour vérifier les faits, et ont souvent des « hallucinations » : ils génèrent des informations apparemment plausibles, mais erronées. De plus, sans personnalisation supplémentaire, ils manquent de connaissances sur les entreprises, les produits ou les contextes utilisateurs spécifiques.

C'est pourquoi les architectures de chatbots modernes intègrent les LLM à plusieurs autres composants essentiels pour créer des systèmes conversationnels véritablement utiles.

Génération augmentée par récupération : ancrer les chatbots dans les faits

Les systèmes RAG fonctionnent en combinant les capacités génératives des modèles de langage avec la précision des systèmes de recherche d'informations. Voici le déroulement typique d'un processus RAG dans un chatbot moderne :

Traitement des requêtes : Lorsqu'un utilisateur pose une question, le système l'analyse pour identifier les besoins d'information clés.

Recherche d'informations : Plutôt que de s'appuyer uniquement sur les données d'apprentissage du LLM, le système effectue des recherches dans les bases de connaissances pertinentes, qui peuvent inclure la documentation de l'entreprise, les catalogues de produits, les FAQ, voire le contenu en direct d'un site web.

Sélection de documents pertinents : Le système de recherche identifie les documents ou passages les plus pertinents en fonction de leur similarité sémantique avec la requête.

Augmentation du contexte : Ces documents récupérés sont fournis au modèle de langage comme contexte supplémentaire lors de la génération de sa réponse.

Génération de réponses : Le LLM produit une réponse intégrant à la fois ses capacités linguistiques générales et les informations spécifiques récupérées.

Attribution des sources : De nombreux systèmes RAG identifient également les sources ayant contribué à la réponse, permettant ainsi la citation ou la vérification.

Cette approche combine le meilleur des deux mondes : la capacité du LLM à comprendre les questions et à générer un langage naturel, avec la précision et l'actualité des informations issues des systèmes de récupération. Le résultat est un chatbot capable de fournir des informations précises et factuelles sur les produits, les politiques ou les services, sans hallucination.

Prenons l'exemple d'un chatbot de service client e-commerce. Interrogé sur les politiques de retour d'un produit spécifique, un LLM pur peut générer une réponse plausible, mais potentiellement incorrecte, en s'appuyant sur des schémas généraux observés lors de l'apprentissage. Un chatbot optimisé par RAG récupérerait plutôt le document de politique de retour de l'entreprise, trouverait la section pertinente concernant cette catégorie de produits et générerait une réponse reflétant fidèlement la politique en vigueur.

La sophistication des systèmes RAG ne cesse de progresser. Les implémentations modernes utilisent des représentations vectorielles continues denses pour représenter les requêtes et les documents dans un espace sémantique de grande dimension, permettant une recherche basée sur le sens plutôt que sur la simple correspondance de mots-clés. Certains systèmes utilisent des pipelines de recherche en plusieurs étapes, explorant d'abord un large éventail de données, puis affinant les résultats par reclassement. D'autres déterminent dynamiquement quand la recherche est nécessaire et quand le LLM peut répondre en toute sécurité à partir de ses connaissances paramétriques.

Pour les entreprises qui mettent en œuvre des chatbots, une mise en œuvre efficace du RAG nécessite une préparation minutieuse de la base de connaissances : organisation des informations en blocs récupérables, mise à jour régulière du contenu et structuration des données pour faciliter une recherche précise. Correctement implémenté, le RAG améliore considérablement la précision des chatbots, en particulier pour les applications spécifiques à un domaine où la précision est cruciale.

Gestion de l'état conversationnel : maintenir le contexte

Les chatbots modernes utilisent des systèmes sophistiqués de gestion de l'état conversationnel pour maintenir des échanges cohérents et contextuels. Ces systèmes suivent non seulement le contenu explicite des messages, mais aussi le contexte implicite que les humains conservent naturellement pendant les conversations.

La forme la plus élémentaire de gestion de l'état conversationnel est le suivi de l'historique des conversations. Le système conserve une mémoire tampon des échanges récents (à la fois les saisies de l'utilisateur et ses propres réponses) qui est fournie au modèle de langage à chaque nouvelle requête. Cependant, à mesure que les conversations s'allongent, inclure l'historique complet devient difficile en raison des limitations de longueur du contexte, même pour les LLM les plus avancés.

Pour répondre à cette contrainte, les chatbots sophistiqués utilisent plusieurs techniques :

Résumé : condenser périodiquement les premières parties de la conversation en résumés concis qui capturent les informations clés tout en réduisant l'utilisation de jetons.

Suivi des entités : surveiller explicitement les entités importantes (personnes, produits, problèmes) mentionnées tout au long de la conversation et les maintenir structurées.

Analyse des étapes de la conversation : suivre l'état d'avancement de la conversation dans un processus, qu'il s'agisse de recueillir des informations, de proposer des solutions ou de confirmer des actions.

Persistance du contexte utilisateur : conserver les informations utilisateur pertinentes d'une session à l'autre, telles que les préférences, l'historique des achats ou les détails du compte (avec des contrôles de confidentialité appropriés).

Mémoire d'intention : mémoriser l'objectif initial de l'utilisateur, même en cas de détours et de clarifications dans la conversation.

Examinons un scénario de service client : un utilisateur demande une mise à niveau de son abonnement, puis pose plusieurs questions détaillées sur les fonctionnalités, les comparaisons de prix et les cycles de facturation, avant de finalement décider de procéder à la mise à niveau. Un système efficace de gestion des états conversationnels garantit que lorsque l'utilisateur dit « Oui, c'est parti », le chatbot comprend exactement ce que « ça » signifie (la mise à niveau) et conserve tous les détails pertinents de la conversation.

La mise en œuvre technique de la gestion des états varie selon les plateformes. Certains systèmes utilisent une approche hybride, combinant le suivi des états symboliques (modélisation explicite des entités et des intentions) avec les capacités implicites des grandes fenêtres contextuelles des LLM modernes. D'autres utilisent des modules de mémoire spécialisés qui récupèrent sélectivement les parties pertinentes de l'historique des conversations en fonction de la requête en cours.

Pour les applications complexes comme le service client ou la vente, la gestion des états s'intègre souvent à la modélisation des processus métier, permettant aux chatbots de guider les conversations à travers des flux de travail définis tout en préservant la flexibilité nécessaire à une interaction naturelle. Les implémentations les plus avancées peuvent même suivre l'état émotionnel en plus du contexte factuel, ajustant ainsi le style de communication en fonction du sentiment utilisateur détecté.

Une gestion efficace du contexte transforme les interactions des chatbots, passant d'échanges de questions-réponses décousus à des conversations authentiques, fondées sur une compréhension partagée – un facteur essentiel de satisfaction utilisateur et de taux d'achèvement des tâches.

Compréhension du langage naturel : interprétation de l'intention de l'utilisateur

Les systèmes modernes de CLN des chatbots remplissent généralement plusieurs fonctions clés :

Reconnaissance de l'intention : identifier l'objectif sous-jacent de l'utilisateur. Cherche-t-il à effectuer un achat, signaler un problème, demander des informations ou autre chose ? Les systèmes avancés peuvent reconnaître des intentions multiples ou imbriquées dans un même message.

Extraction d'entités : identifier et catégoriser des informations spécifiques dans le message de l'utilisateur. Par exemple, dans « Je dois changer mon vol de Chicago à Boston jeudi », les entités incluent les lieux (Chicago, Boston) et l'heure (jeudi).

Analyse des sentiments : détecter le ton et l'attitude émotionnels, ce qui aide le chatbot à ajuster son style de réponse. L'utilisateur est-il frustré, excité, confus ou neutre ?

Identification de la langue : Déterminer la langue parlée par l'utilisateur pour fournir des réponses appropriées dans des environnements multilingues.

Alors que les plateformes de chatbots précédentes nécessitaient une programmation explicite des intentions et des entités, les systèmes modernes exploitent les capacités de compréhension du langage inhérentes aux LLM. Cela leur permet de gérer un éventail d'expressions beaucoup plus large sans nécessiter une énumération exhaustive des formulations possibles.

Lorsqu'un utilisateur saisit « Le processus de paiement se bloque constamment sur la page de paiement », un système de TAL sophistiqué identifie cette intention comme une intention de support technique, extrait les entités « processus de paiement » et « page de paiement » comme pertinentes, détecte la frustration liée au sentiment et transmet ces informations au processus de génération de réponses approprié.

La précision du TAL a un impact significatif sur la satisfaction des utilisateurs. Lorsqu'un chatbot interprète systématiquement mal les requêtes, les utilisateurs perdent rapidement confiance et patience. Pour améliorer la précision, de nombreux systèmes utilisent des scores de confiance : lorsque la confiance dans la compréhension descend en dessous d'un certain seuil, le chatbot peut poser des questions de clarification plutôt que de partir d'hypothèses potentiellement erronées.

Pour les applications spécifiques à un domaine, les systèmes de TAL intègrent souvent une terminologie spécialisée et la reconnaissance du jargon. Un chatbot de santé, par exemple, serait formé à reconnaître les termes et symptômes médicaux, tandis qu'un robot de services financiers comprendrait la terminologie bancaire et les types de transactions.

L'intégration du NLU aux autres composants est cruciale. Les intentions et entités extraites alimentent les processus de récupération, contribuent au maintien de l'état conversationnel et guident la génération de réponses, servant de lien essentiel entre les propos des utilisateurs et les actions du système.

Testez VOTRE Entreprise en Minutes

Créez votre compte et lancez votre chatbot IA en quelques minutes. Entièrement personnalisable, aucun codage requis - commencez à engager vos clients instantanément!

Génération et optimisation des réponses

Dans les systèmes modernes, la génération de réponses comprend généralement plusieurs étapes :

Planification de la réponse : Déterminer les informations à inclure, les questions à poser ou les actions à suggérer en fonction de l'état actuel de la conversation et des connaissances disponibles.

Sélection du contenu : Choisir les faits, explications ou options spécifiques à présenter parmi des ensembles potentiellement importants d'informations pertinentes.

Structure : Organiser le contenu sélectionné selon une séquence logique et facile à suivre, répondant efficacement aux besoins de l'utilisateur.

Réalisation : Convertir le contenu planifié en un langage naturel et fluide, adapté au ton et au style souhaités par le chatbot.

Bien que les LLM puissent générer un texte remarquablement cohérent, une génération incontrôlée entraîne souvent des problèmes tels qu'une verbosité excessive, l'inclusion d'informations non pertinentes ou des réponses non conformes aux objectifs de l'entreprise. Pour résoudre ces problèmes, les systèmes de chatbot sophistiqués mettent en œuvre diverses techniques d'optimisation :

Modèles de réponse : Pour les scénarios courants avec des besoins d'information prévisibles, de nombreux systèmes utilisent des modèles paramétrés qui garantissent des réponses cohérentes et efficaces tout en permettant la personnalisation.

Contrôle de la longueur : Mécanismes permettant d'ajuster la longueur des réponses en fonction de la complexité de la requête, de la plateforme sur laquelle l'interaction a lieu et des préférences de l'utilisateur.

Orientation sur le ton et le style : Instructions permettant d'ajuster la formalité, la convivialité ou le niveau technique des réponses en fonction du contexte de la conversation et des caractéristiques de l'utilisateur.

Planification multi-tours : Pour les sujets complexes, les systèmes peuvent planifier les réponses sur plusieurs tours, en décomposant intentionnellement l'information en fragments compréhensibles plutôt que de submerger les utilisateurs sous des murs de texte.

Intégration de la logique métier : Règles garantissant l'adéquation des réponses aux politiques de l'entreprise, aux exigences réglementaires et aux capacités du service.

Les chatbots les plus efficaces utilisent également des stratégies de réponse adaptatives. Ils surveillent les signaux d'engagement et de satisfaction des utilisateurs afin d'affiner leur approche de communication au fil du temps. Si les utilisateurs demandent fréquemment des éclaircissements après un certain type de réponse, le système peut s'adapter automatiquement pour fournir des explications plus détaillées dans des scénarios futurs similaires.

La gestion de l'incertitude est un aspect crucial de la génération de réponses. Lorsque les informations sont indisponibles ou ambiguës, les systèmes bien conçus reconnaissent les limites plutôt que de générer des réponses apparemment sûres, mais potentiellement erronées. Cette transparence renforce la confiance et gère efficacement les attentes des utilisateurs.

Pour les applications critiques comme la santé ou les services financiers, de nombreuses implémentations incluent des mécanismes de vérification humaine pour certains types de réponses avant qu'elles ne parviennent aux utilisateurs. Ces garde-fous offrent un niveau supplémentaire de contrôle qualité pour les interactions à enjeux élevés.

Modules spécialisés pour les actions et l'intégration

Ces capacités d'action sont mises en œuvre via des modules spécialisés qui connectent l'interface conversationnelle à des systèmes externes :

Intégration API : couche middleware qui traduit les requêtes conversationnelles en appels API correctement formatés vers divers services back-end : systèmes de commande, plateformes CRM, processeurs de paiement, systèmes de réservation, etc.

Authentification et autorisation : composants de sécurité qui vérifient l'identité et les niveaux d'autorisation des utilisateurs avant d'effectuer des actions sensibles ou d'accéder à des informations protégées.

Aide au remplissage de formulaires : modules qui aident les utilisateurs à remplir des formulaires complexes par le biais d'interactions conversationnelles, en collectant les informations requises élément par élément plutôt que de présenter des formulaires complexes.

Traitement des transactions : composants qui gèrent les processus en plusieurs étapes, tels que les achats, les réservations ou les modifications de compte, en maintenant l'état tout au long du processus et en gérant les exceptions avec élégance.

Systèmes de notification : Capacité d'envoyer des mises à jour, des confirmations ou des alertes via différents canaux (e-mail, SMS, notifications intégrées à l'application) au fur et à mesure de l'avancement ou de la fin des actions.

La sophistication de ces intégrations varie considérablement selon les implémentations. Les chatbots simples peuvent inclure une fonctionnalité de transfert de base qui transfère les utilisateurs à des agents humains ou à des systèmes spécialisés lorsqu'une action est requise. Les implémentations plus avancées offrent des expériences de bout en bout fluides, le chatbot gérant l'intégralité du processus au sein de la conversation.

Imaginez un chatbot de compagnie aérienne aidant un passager à modifier son vol. Il doit :

Authentifier l'utilisateur et récupérer sa réservation ;

Rechercher des vols alternatifs disponibles ;

Calculer les différences de tarifs ou les frais de modification ;

Traiter le paiement si nécessaire ;

Émettre de nouvelles cartes d'embarquement ;

Mettre à jour la réservation dans plusieurs systèmes ;

Envoyer les informations de confirmation via les canaux préférés.

Pour ce faire, l'intégration avec les systèmes de réservation, les processeurs de paiement, les services d'authentification et les plateformes de notification est nécessaire, le tout orchestré par le chatbot, tout en maintenant un flux de conversation naturel.

Pour les entreprises qui développent des chatbots orientés action, cette couche d'intégration représente souvent l'effort de développement le plus important. Si les composants conversationnels bénéficient des avancées de l'IA polyvalente, ces intégrations doivent être conçues sur mesure pour s'adapter à l'environnement système spécifique de chaque organisation.

Les considérations de sécurité sont particulièrement importantes pour les chatbots orientés action. Les bonnes pratiques incluent la mise en œuvre d'une authentification appropriée avant les opérations sensibles, la tenue de journaux d'audit détaillés de toutes les actions effectuées, la fourniture d'étapes de confirmation claires pour les activités consécutives et la conception d'une gestion des échecs en cas de problème d'intégration.

À mesure que ces capacités d'intégration progressent, la frontière entre interfaces conversationnelles et applications traditionnelles s'estompe. Les implémentations les plus sophistiquées permettent aujourd'hui aux utilisateurs d'accomplir des tâches complexes entièrement par conversation naturelle, ce qui nécessitait auparavant de naviguer sur plusieurs écrans dans les applications traditionnelles.

Formation et amélioration continue

Plusieurs approches de formation et d'amélioration fonctionnent de concert :

Affinement du modèle de base : Les modèles de langage de base qui alimentent les chatbots peuvent être davantage spécialisés grâce à un entraînement supplémentaire sur des données spécifiques au domaine. Ce processus, appelé affinement, aide le modèle à adopter la terminologie, les schémas de raisonnement et les connaissances du domaine appropriés à des applications spécifiques.

Apprentissage par renforcement à partir du feedback humain (RLHF) : Cette technique utilise des évaluateurs humains pour évaluer les réponses du modèle, créant ainsi des données de préférence qui entraînent les modèles de récompense. Ces modèles de récompense guident ensuite le système vers la génération de résultats plus utiles, plus précis et plus sûrs. Le RLHF a joué un rôle crucial dans la transformation des modèles de langage, autrefois générateurs impressionnants mais peu fiables, en assistants pratiques.

Exploration de conversations : Systèmes d'analyse qui traitent des journaux de conversations anonymisés pour identifier les schémas, les questions courantes, les points d'échec fréquents et les solutions de résolution efficaces. Ces informations permettent à la fois d'automatiser les améliorations et de guider les ajustements effectués par l'humain.

Apprentissage actif : des systèmes identifient les zones d'incertitude et les signalent pour examen humain, concentrant ainsi l'effort humain sur les opportunités d'amélioration les plus pertinentes.

Tests A/B : cadres expérimentaux comparant différentes stratégies de réponse avec des utilisateurs réels afin de déterminer les approches les plus efficaces dans différents scénarios.

Pour les chatbots d'entreprise, le processus de formation commence généralement par des données historiques : transcriptions des précédents entretiens avec le service client, documentation et informations produit. Cette formation initiale est ensuite complétée par des exemples de conversations soigneusement conçus qui illustrent la gestion optimale de scénarios courants.

Une fois déployés, les systèmes efficaces intègrent des mécanismes de feedback permettant aux utilisateurs d'indiquer si les réponses ont été utiles. Ce feedback, combiné à des signaux implicites comme l'abandon de la conversation ou la répétition des questions, crée un riche ensemble de données pour une amélioration continue.

Le rôle humain dans la formation des chatbots modernes reste essentiel. Les concepteurs de conversation façonnent la personnalité et les schémas de communication fondamentaux. Les experts métier examinent et corrigent les réponses proposées pour en vérifier l'exactitude technique. Les data scientists analysent les indicateurs de performance pour identifier les opportunités d'amélioration. Les implémentations les plus réussies considèrent le développement de chatbots comme un partenariat collaboratif homme-IA plutôt que comme un processus entièrement automatisé.

Pour les entreprises qui mettent en œuvre des chatbots, il est essentiel d'établir un cadre d'amélioration clair. Cela comprend :

Des cycles réguliers d'évaluation des performances

Un personnel dédié au suivi et à l'amélioration

Des indicateurs de réussite clairs

Des processus d'intégration des retours utilisateurs

Une gouvernance pour la gestion de la qualité des données d'entraînement

Bien que les approches spécifiques varient selon les plateformes et les applications, le principe fondamental reste le même : les chatbots modernes sont des systèmes dynamiques qui s'améliorent grâce à l'utilisation, aux retours et à des améliorations délibérées, plutôt que des programmes statiques figés dans leurs capacités initiales.

Garanties et considérations éthiques

These safeguards typically include:

Content Filtering: Systems that detect and prevent harmful, offensive, or inappropriate content in both user inputs and model outputs. Modern implementations use specialized models specifically trained to identify problematic content across various categories.

Scope Enforcement: Mechanisms that keep conversations within appropriate domains, preventing chatbots from being manipulated into providing advice or information outside their intended purpose and expertise.

Data Privacy Controls: Protections for sensitive user information, including data minimization principles, anonymization techniques, and explicit consent mechanisms for data storage or usage.

Bias Mitigation: Processes that identify and reduce unfair biases in training data and model outputs, ensuring equitable treatment across different user groups.

External Reference Verification: For factual claims, particularly in sensitive domains, systems that verify information against trusted external sources before presenting it to users.

Human Oversight: For critical applications, review mechanisms that enable human monitoring and intervention when necessary, particularly for consequential decisions or sensitive topics.

The implementation of these safeguards involves both technical and policy components. At the technical level, various filtering models, detection algorithms, and monitoring systems work together to identify problematic interactions. At the policy level, clear guidelines define appropriate use cases, required disclaimers, and escalation paths.

Healthcare chatbots provide a clear example of these principles in action. Well-designed systems in this domain typically include explicit disclaimers about their limitations, avoid diagnostic language unless medically validated, maintain strict privacy controls for health information, and include clear escalation paths to human medical professionals for appropriate concerns.

For businesses implementing chatbots, several best practices have emerged:

Start with clear ethical guidelines and use case boundaries

Implement multiple layers of safety mechanisms rather than relying on a single approach

Test extensively with diverse user groups and scenarios

Establish monitoring and incident response protocols

Provide transparent information to users about the system's capabilities and limitations

As conversational AI becomes more powerful, the importance of these safeguards only increases. The most successful implementations balance innovation with responsibility, ensuring that chatbots remain helpful tools that enhance human capabilities rather than creating new risks or harms.

The Future of Chatbot Technology

While today's chatbots have come remarkably far from their primitive ancestors, the technology continues to evolve rapidly. Several emerging trends indicate where conversational AI is headed in the near future:

Multimodal Capabilities: The next generation of chatbots will move beyond text to seamlessly incorporate images, voice, video, and interactive elements. Users will be able to show problems through their camera, hear explanations with visual aids, and interact through whatever medium is most convenient for their current context.

Agentic Behaviors: Advanced chatbots are moving from reactive question-answering to proactive problem-solving. These "agentic" systems can take initiative, break complex tasks into steps, use tools to gather information, and persist until objectives are achieved – more like virtual assistants than simple chatbots.

Memory and Personalization: Future systems will maintain more sophisticated long-term memory of user preferences, past interactions, and relationship history. This persistent understanding will enable increasingly personalized experiences that adapt to individual communication styles, knowledge levels, and needs.

Specialized Domain Experts: While general-purpose chatbots will continue to improve, we're also seeing the emergence of highly specialized systems with deep expertise in specific domains – legal assistants with comprehensive knowledge of case law, medical systems trained on clinical literature, or financial advisors versed in tax codes and regulations.

Collaborative Intelligence: The line between human and AI responsibilities will continue to blur, with more sophisticated collaboration models where chatbots and human experts work together seamlessly, each handling aspects of customer interaction where they excel.

Emotional Intelligence: Advancements in affect recognition and appropriate emotional response generation will create more naturally empathetic interactions. Future systems will better recognize subtle emotional cues and respond with appropriate sensitivity to user needs.

Federated and On-Device Processing: Privacy concerns are driving development of architectures where more processing happens locally on user devices, with less data transmitted to central servers. This approach promises better privacy protection while maintaining sophisticated capabilities.

These advancements will enable new applications across industries. In healthcare, chatbots may serve as continuous health companions, monitoring conditions and coordinating care across providers. In education, they might function as personalized tutors adapting to individual learning styles and progress. In professional services, they could become specialized research assistants that dramatically amplify human expertise.

However, these capabilities will also bring new challenges. More powerful systems will require more sophisticated safety mechanisms. Increasingly human-like interactions will raise new questions about appropriate disclosure of AI identity. And as these systems become more integrated into daily life, ensuring equitable access and preventing harmful dependencies will become important social considerations.

What seems clear is that the line between chatbots and other software interfaces will continue to blur. Natural language is simply the most intuitive interface for many human needs, and as conversational AI becomes more capable, it will increasingly become the default way we interact with digital systems. The future isn't just about better chatbots – it's about conversation becoming the primary human-computer interface for many applications.

Conclusion : la conversation en cours

Cette architecture complexe permet des expériences qui auraient semblé relever de la science-fiction il y a seulement dix ans : des conversations naturelles avec des systèmes numériques capables de répondre à des questions, de résoudre des problèmes et d'effectuer des actions à notre place. Pourtant, nous n'en sommes qu'aux prémices du développement de cette technologie. Les capacités et les applications de l'IA conversationnelle continueront de se développer rapidement dans les années à venir.

Pour les entreprises et les organisations souhaitant mettre en œuvre la technologie des chatbots, la compréhension de ces composants sous-jacents est essentielle pour définir des attentes réalistes, faire des choix de conception éclairés et créer des expériences utilisateur véritablement enrichissantes. Les implémentations les plus réussies ne considèrent pas les chatbots comme des boîtes noires magiques, mais plutôt comme des outils sophistiqués dont les capacités et les limites doivent être gérées avec soin.

Pour les utilisateurs interagissant avec ces systèmes, un aperçu des coulisses peut aider à démystifier ce qui ressemble parfois à de la magie technologique. Comprendre les principes fondamentaux du fonctionnement des chatbots modernes permet une interaction plus efficace : savoir quand ils peuvent aider, quand ils peuvent rencontrer des difficultés et comment communiquer avec eux au mieux.

Le plus remarquable dans la technologie des chatbots, c'est peut-être la rapidité avec laquelle nos attentes s'adaptent. Des fonctionnalités qui nous auraient étonnés il y a quelques années deviennent rapidement la base que nous tenons pour acquise. Cette normalisation rapide illustre le fonctionnement naturel de la conversation comme interface : lorsqu'elle est bien menée, elle disparaît tout simplement, nous laissant nous concentrer sur la résolution des problèmes et l'exécution des tâches plutôt que sur la technologie elle-même.

À mesure que ces systèmes évoluent, la conversation entre humains et machines deviendra de plus en plus fluide et productive, ne remplaçant pas la connexion humaine, mais augmentant nos capacités et nous permettant de nous concentrer sur les aspects spécifiquement humains de notre travail et de notre vie.