Test AI op UW website in 60 seconden

Zie hoe onze AI uw website direct analyseert en een gepersonaliseerde chatbot creëert - zonder registratie. Voer gewoon uw URL in en zie hoe het werkt!

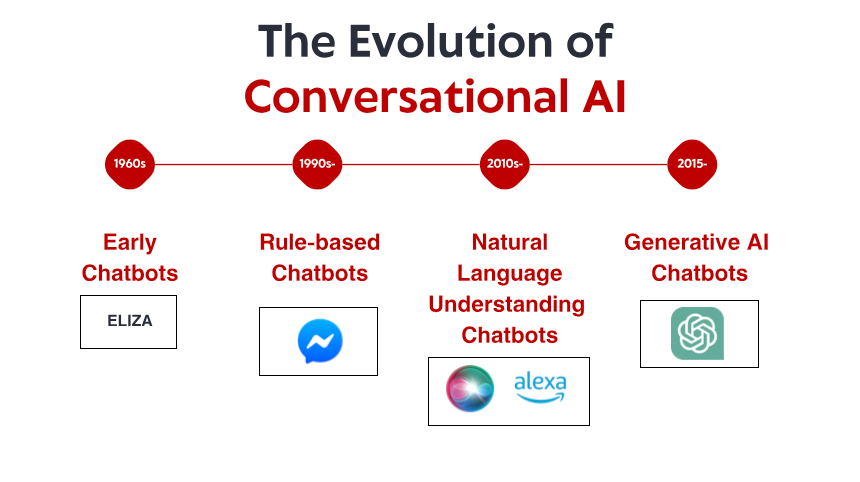

De evolutie en impact van conversationele AI

Conversationele AI heeft zich de afgelopen tien jaar enorm ontwikkeld en is getransformeerd van eenvoudige, op regels gebaseerde chatbots naar geavanceerde systemen die in staat zijn tot genuanceerde interacties in meerdere contexten. Van klantenservice-applicaties tot tools voor geestelijke gezondheidszorg, spraakassistenten tot engines voor contentcreatie, deze technologieën zijn diep geïntegreerd in onze persoonlijke en professionele levenssfeer.

Deze snelle acceptatie brengt diepgaande ethische overwegingen met zich mee waar ontwikkelaars, bedrijven en de maatschappij rekening mee moeten houden. Als adviseur bij AI-implementatieprojecten in verschillende sectoren heb ik met eigen ogen gezien hoe ethische missers tijdens de ontwerpfase tot problematische resultaten kunnen leiden zodra deze systemen gebruikers bereiken. In deze blog onderzoeken we de ethische aspecten waarmee we rekening moeten houden bij het creëren van conversationele AI-systemen die de mensheid echt dienen.

Privacy en gegevensverwerking: respect voor gebruikersgrenzen

Privacyoverwegingen bij conversationele AI moeten verder gaan dan de basisnaleving van regelgeving zoals de AVG of CCPA. Ze moeten een fundamenteel respect voor de grenzen en verwachtingen van gebruikers weerspiegelen, vooral wanneer deze systemen zijn ontworpen om persoonlijke informatie te verzamelen. Belangrijke overwegingen zijn onder andere:

Transparante dataverzamelingspraktijken: Gebruikers verdienen het om precies te weten welke informatie wordt verzameld, hoe lang deze wordt bewaard en hoe deze wordt gebruikt – alles uitgelegd in toegankelijke taal, niet in juridisch jargon.

Betekenisvolle toestemmingsmechanismen: Toestemming moet actief, geïnformeerd en gedetailleerd zijn. Gebruikers moeten zich kunnen in- of uitschrijven voor specifiek datagebruik zonder de toegang tot kernfunctionaliteiten te verliezen.

Principes voor dataminimalisatie: Systemen zouden alleen moeten verzamelen wat nodig is om de service te bieden die gebruikers verwachten, in plaats van aanvullende gegevens te verzamelen die waardevol kunnen zijn voor het bedrijf, maar niet relevant voor de directe behoeften van de gebruiker.

Veilige verwerkingspraktijken: Robuuste encryptie, toegangscontrole en regelmatige beveiligingsaudits zouden standaardpraktijk moeten zijn, met bijzondere aandacht voor gevoelige gesprekken.

De meest ethische conversationele AI-systemen zijn systemen die zijn ontworpen met privacy als basiswaarde in plaats van een compliance-vinkje – waarbij het beschermen van gebruikersinformatie wordt gezien als een kernfunctie in plaats van een beperking die omzeild kan worden.

Het aanpakken van vooringenomenheid en eerlijkheid in AI-gesprekken

Biases in conversationele AI kunnen zich op verschillende manieren manifesteren:

Representatiebias: Wanneer bepaalde demografische groepen over- of ondervertegenwoordigd zijn in trainingsdata.

Interactiebias: Wanneer het systeem anders reageert op gebruikers op basis van waargenomen identiteitskenmerken.

Uitkomstbias: Wanneer het systeem verschillende resultaten produceert voor verschillende gebruikersgroepen.

Het aanpakken van deze biases vereist een bewuste inspanning gedurende de gehele ontwikkelingscyclus:

Ten eerste moeten trainingsdata kritisch worden geëvalueerd en gewogen, met bijzondere aandacht voor het opnemen van diverse perspectieven en ervaringen. Dit betekent dat er verder moet worden gekeken dan standaarddatasets om ook stemmen te integreren die anders mogelijk gemarginaliseerd zouden worden.

Ten tweede moeten doorlopende tests diverse gebruikersgroepen omvatten en moet worden gemonitord op prestatieverschillen. Het gaat hierbij niet alleen om testen met verschillende demografische groepen, maar ook om het overwegen van uiteenlopende contexten, vaardigheden en interactiestijlen.

Ten derde moeten ontwerpteams zelf mensen met diverse achtergronden en perspectieven omvatten die potentiële vooroordelen kunnen identificeren die homogene teams mogelijk over het hoofd zien.

Ten slotte moeten systemen continu worden gemonitord en bijgewerkt naarmate maatschappelijke normen evolueren en nieuwe vooroordelen worden geïdentificeerd. De meest ethische conversationele AI-systemen zijn niet alleen eerlijk bij de lancering – ze zijn ontworpen om in de loop der tijd steeds rechtvaardiger te worden.

Transparantie en uitlegbaarheid: het recht op begrip

Transparantie in conversationele AI omvat verschillende dimensies:

Openbaarmaking van de AI-identiteit: Gebruikers moeten weten wanneer ze met een AI communiceren in plaats van met een mens. Misleidende praktijken die deze grens opzettelijk vervagen, schenden de autonomie van de gebruiker.

Procestransparantie: Gebruikers verdienen het om te begrijpen hoe hun input de output van het systeem beïnvloedt, met name bij belangrijke beslissingen zoals leningaanvragen, medische aanbevelingen of toewijzing van middelen.

Transparantie van beperkingen: Systemen moeten openhartig zijn over hun mogelijkheden en beperkingen, in plaats van valse zekerheid of expertise uit te stralen.

Uitlegmogelijkheden: Indien van toepassing moeten systemen hun aanbevelingen of beslissingen kunnen uitleggen in termen die gebruikers kunnen begrijpen.

Naast deze specifieke praktijken speelt een bredere filosofische vraag over de mate van transparantie die gebruikers verdienen. Hoewel volledige algoritmische transparantie niet altijd haalbaar of noodzakelijk is, zouden gebruikers toegang moeten hebben tot zinvolle uitleg die past bij de context en de gevolgen van de interactie.

De meest ethische conversationele AI-systemen zijn systemen die gebruikers in staat stellen om te begrijpen in plaats van blind vertrouwen te vragen.

Gebruikersautonomie en -controle: ontwerpen voor menselijk handelen

Het respecteren van de autonomie van de gebruiker in het ontwerp van conversationele AI betekent het creëren van systemen die:

Expliciete grenzen respecteren: Wanneer een gebruiker "nee" zegt of aangeeft een gesprek te willen beëindigen, moet het systeem dat respecteren zonder manipulatieve vasthoudendheid.

Zinvolle keuzes bieden: Gebruikers moeten echte opties hebben, geen geconstrueerde keuzes die allemaal tot hetzelfde resultaat leiden.

Correctie mogelijk maken: Wanneer een systeem een fout verkeerd begrijpt of maakt, moeten gebruikers eenvoudige manieren hebben om deze te corrigeren.

Aanpassing mogelijk maken: Gebruikers moeten de interactiestijl en -parameters kunnen aanpassen aan hun voorkeuren en behoeften.

Behoud menselijk toezicht: Voor belangrijke beslissingen moeten er toegankelijke paden zijn naar menselijke beoordeling.

De spanning tussen ontwerpen voor efficiëntie en het respecteren van de autonomie van de gebruiker is met name duidelijk zichtbaar in overtuigende toepassingen zoals verkoop- of gedragsveranderingssystemen. Ethische grenzen vervagen wanneer conversationele AI psychologische tactieken inzet om gebruikersbeslissingen te beïnvloeden, zelfs wanneer het beoogde resultaat de gebruiker ten goede zou kunnen komen.

De meest ethische conversationele AI-systemen geven duidelijk de voorkeur aan gebruikerscontrole boven systeemgemak of bedrijfsdoelstellingen.

Test AI op UW website in 60 seconden

Zie hoe onze AI uw website direct analyseert en een gepersonaliseerde chatbot creëert - zonder registratie. Voer gewoon uw URL in en zie hoe het werkt!

Toegankelijkheid en inclusie: ontwerpen voor iedereen

Echt ethische conversationele AI moet toegankelijk zijn voor mensen met diverse mogelijkheden, talen, culturele referenties en technische vaardigheden. Dit betekent:

Ondersteuning van meerdere invoermethoden: Tekst, spraak en andere modaliteiten moeten beschikbaar zijn om tegemoet te komen aan verschillende behoeften en voorkeuren.

Aanpassing aan diverse communicatiestijlen: Systemen moeten variaties in taalgebruik, waaronder accenten, dialecten en onconventionele syntaxis, kunnen verwerken.

Passende alternatieven bieden: Wanneer een gebruiker moeite heeft met de AI-interface, moeten er duidelijke mogelijkheden zijn om alternatieve ondersteuning te vinden.

Culturele gevoeligheid: Systemen moeten culturele verschillen in communicatiepatronen en verwachtingen erkennen en respecteren.

Toegankelijkheid is niet alleen een technische uitdaging – het is een fundamentele ethische overweging die bepaalt wie profiteert van deze technologieën en wie achterblijft. Wanneer conversationele AI primair wordt ontworpen voor gebruikers die passen bij het profiel van de ontwikkelaars, creëert dit onvermijdelijk digitale kloven die bestaande ongelijkheden versterken.

De meest ethische conversationele AI-systemen zijn systemen die zijn ontworpen met het expliciete doel om diverse doelgroepen te bedienen, niet alleen de gemakkelijkste of meest winstgevende gebruikerssegmenten.

Het vermijden van uitbuiting en manipulatie: vertrouwen opbouwen

Ethische overwegingen rond manipulatie en uitbuiting zijn onder andere:

Emotionele manipulatie: Systemen mogen geen misbruik maken van menselijke neigingen om AI te antropomorfiseren of er een band mee te vormen, vooral niet wanneer deze verbindingen commerciële belangen dienen.

Duistere patronen: Conversatiestromen mogen niet zo ontworpen zijn dat gebruikers in verwarring worden gebracht en keuzes maken die ze anders niet zouden maken.

Bewustzijn van kwetsbaarheid: Systemen moeten gebruikers herkennen en tegemoetkomen die mogelijk bijzonder vatbaar zijn voor beïnvloeding, zoals kinderen, mensen in crisis of mensen met cognitieve beperkingen.

Commerciële transparantie: Wanneer conversationele AI commerciële doeleinden dient, moeten deze motieven expliciet zijn in plaats van vermomd als behulpzaamheid of zorgzaamheid.

De grens tussen behulpzame overreding en onethische manipulatie is niet altijd even scherp. Een assistent voor geestelijke gezondheidszorg die consistente betrokkenheid aanmoedigt, kan de belangen van de gebruiker oprecht dienen, terwijl een identiek interactiepatroon dat abonnementsupgrades verkoopt ethische bezwaren oproept.

De meest ethische conversationele AI-systemen onderhouden eerlijke relaties met gebruikers en geven prioriteit aan oprechte hulp boven geconstrueerde betrokkenheid of strategische uitbuiting van de menselijke psychologie.

Verantwoordelijkheid en verantwoording: wanneer AI de fout in gaat

Naarmate conversationele AI-systemen steeds belangrijkere rollen krijgen, worden vragen over verantwoordelijkheid urgenter:

Duidelijke verantwoordelijkheid voor de resultaten: Organisaties die AI-systemen implementeren, moeten verantwoordelijkheid nemen voor de impact ervan in plaats van de schuld af te schuiven op technologie, gebruikers of externe ontwikkelaars.

Passende aansprakelijkheidskaders: Wettelijke en regelgevende structuren moeten evolueren om schade veroorzaakt door AI-systemen aan te pakken, met name in risicovolle domeinen.

Toegankelijke verhaalmechanismen: Gebruikers die getroffen worden door AI-fouten of -schade, hebben duidelijke, toegankelijke manieren nodig om een oplossing te zoeken.

Continue monitoring en verbetering: Organisaties hebben een ethische plicht om actief te monitoren op onbedoelde gevolgen en problemen proactief aan te pakken.

De uitdagingen van attributie in complexe AI-systemen maken verantwoordingsplicht complex, maar daarom niet minder essentieel. Wanneer meerdere partijen bijdragen aan een systeem – van dataleveranciers en modelontwikkelaars tot implementerende organisaties – kan de verantwoordelijkheid diffuus worden, waardoor gebruikers geen duidelijk verhaal hebben wanneer er iets misgaat.

De meest ethische implementaties van conversationele AI bevatten robuuste verantwoordingskaders die ervoor zorgen dat iemand antwoordt wanneer gebruikers vragen: "Wie is hiervoor verantwoordelijk?"

Praktische kaders voor ethisch AI-ontwerp

Praktische benaderingen voor ethisch AI-ontwerp zijn onder andere:

Waardegevoelige ontwerpmethodologieën: Kernwaarden expliciet identificeren in een vroeg stadium van het ontwikkelingsproces en de implementatie ervan traceren via technische keuzes.

Betrokkenheid van diverse belanghebbenden: Niet alleen technische experts, maar ook ethici, domeinspecialisten en – cruciaal – vertegenwoordigers van gebruikersgemeenschappen, met name degenen die waarschijnlijk het meest negatief worden beïnvloed.

Ethische risicobeoordelingen: Mogelijke nadelen en voordelen voor verschillende gebruikersgroepen systematisch identificeren vóór implementatie.

Gefaseerde implementatiestrategieën: Systemen geleidelijk introduceren in beperkte contexten met zorgvuldige monitoring vóór een bredere release.

Onafhankelijke ethische beoordeling: Externe evaluatie inwinnen bij personen of instanties zonder financieel belang bij het project.

Ethische training voor ontwikkelteams: Ethische geletterdheid opbouwen bij technische teams om hen te helpen de ethische dimensies van technische beslissingen te herkennen en aan te pakken.

Deze raamwerken gaan niet alleen over het voorkomen van schade, maar ook over het doelbewust creëren van conversationele AI die een positieve bijdrage levert aan het individuele welzijn en het maatschappelijk welzijn.

De meest succesvolle implementaties die ik heb gezien, zijn die waarbij ethiek niet wordt gezien als een belemmering voor innovatie, maar als een cruciale dimensie bij het creëren van echt waardevolle en duurzame AI-systemen.

Conclusie: de weg vooruit

De meest ethische weg vooruit gaat niet over het toepassen van rigide regels of het opleggen van algemene beperkingen. Het gaat veeleer om het ontwikkelen van doordachte processen die menselijke waarden centraal stellen, diverse behoeften erkennen en de menselijke invloed behouden gedurende de ontwikkeling en implementatie van deze steeds krachtiger systemen.

Als gebruikers, ontwikkelaars, regelgevers en burgers spelen we allemaal een rol om ervoor te zorgen dat conversationele AI zich ontwikkelt op manieren die de menselijke autonomie, gelijkheid en het welzijn bevorderen in plaats van aantasten. De vragen die in dit artikel worden gesteld, hebben geen eenvoudige antwoorden, maar door er eerlijk en continu mee aan de slag te gaan, kunnen we werken aan AI-systemen die ons vertrouwen verdienen door hun bewezen toewijding aan ethische principes.

De conversationele AI-systemen die onze aandacht en adoptie het meest waard zijn, zijn die systemen die niet alleen zijn ontworpen voor technische excellentie, maar ook voor ethische excellentie.